INVITE sip:[email protected] SIP/2.0 Via: SIP/2.0/UDP pc33.atlanta.com;branch=z9hG4bKnashds8 To: Bob <[email protected]> From: Alice <[email protected]>;tag=1928301774 Call-ID: a84b4c76e66710 CSeq: 314159 INVITE Max-Forwards: 70 Date: Thu, 21 Feb 2002 13:02:03 GMT Contact: <sip:[email protected]> Content-Type: application/sdp Content-Length: 147 v=0 o=UserA 2890844526 2890844526 IN IP4 here.com s=Session SDP c=IN IP4 pc33.atlanta.com t=0 0 m=audio 49172 RTP/AVP 0 a=rtpmap:0 PCMU/8000

Università degli Studi di Milano

Facoltà di Scienze MM.FF.NN.

Corso di laurea triennale in Informatica

IMS e JAIN SLEE, un’architettura per lo sviluppo di servizi di telecomunicazione a valore aggiunto

Domenico Briganti <[email protected]> v1.0, June 2008

Relatore interno: Prof. Claudio Bettini

Correlatore esterno: Dott. Antonio D’Amato

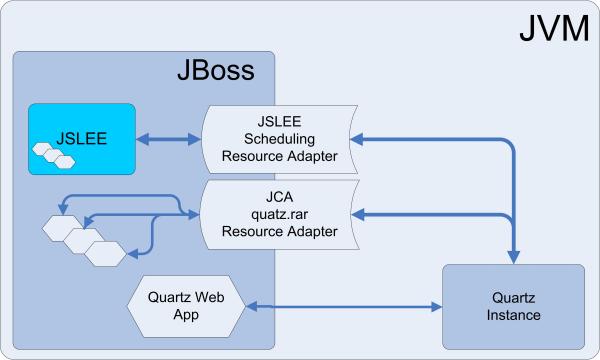

Lo sviluppo dello Scheduling Resource Adaptor

Introduzione

Pochi settori si sviluppano a ritmi frenetici come quelli delle telecomunicazioni. Gli operatori di rete fissa e mobile e i Service Provider operano in un mercato molto competitivo in cui è sempre più difficile realizzare margini a fronte di investimenti che restano comunque elevati.

Il continuo aggiornamento delle tecnologie applicabili alle reti di telecomunicazioni migliora l’efficienza e le prestazioni, è il fattore fondamentale dell’aumento di produttività e redditività, consente una maggiore flessibilità di applicazione e permette una sensibile riduzione dei costi. L’innovazione in questo campo è essenziale quanto, se non più, il Time-To-Marker (TTM), cioè il tempo che trascorre dall’ideazione di un prodotto alla sua effettiva commercializzazione.

L’investire nelle nuove tecnologie per ridurre i costi e cogliere le nuove opportunità offerte dalla convergenza delle reti di comunicazione, dei contenuti e dei dispositivi multimediali risulta quasi obbligatorio.

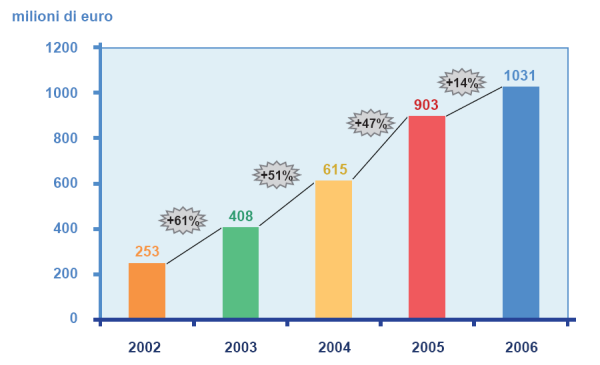

Servizi nuovi stanno nascendo grazie alle tecnologie ora presenti. Servizi a valore aggiunto (VAS), non essenziali come la semplice chiamata, ma che generano grossi ricavi per i player del settore. Gaming on line, download di loghi e suonerie, MMS, SMS Chat, Push-to-Talk ecc. hanno garantito un volume d’affari ogni anno più evidente come è possibile vedere in Figura 1, dati provenienti dall’Osservatorio sui Mobile Context 2007 promosso dalla School of Management del Politecnico di Milano.

— Osservatorio Mobile Content 2007

Per far questo, le società di Telecomunicazione (le cosiddette TLC) hanno bisogno di sistemi che permettano lo sviluppo e la messa in opera di servizi a valore aggiunto in maniera rapida e che interagiscano con altri servizi, molti già esistenti e magari di altri operatori.

Per raggiungere questo obiettivo, i Carrier, nel corso del tempo, si sono uniti sempre più in associazioni il cui scopo è la standardizzazione delle tecnologie usate. Questo agevola l’interoperabilità tra reti di operatori diversi e accelera i tempi di sviluppo di servizi portabili da una piattaforma ad un’altra.

Il gruppo di lavoro congiunto, 3GPP, ha formalizzato una nuova architettura di rete che si basa sugli standard Internet e che si prefigge come la nuova rete per le compagnie telefoniche, indipendentemente dalle loro dimensioni. Questa architettura prende un nome di Next Generation Network (NGN) ed il sistema con cui viene realizzata prende il nome di IMS, Ip Multimedia Subsystem.

La Next Generation Networks è un’evoluzione delle vecchie (ma ancora dominanti) reti di telecomunicazioni PSTN in cui i collegamenti tra gli utenti avvenivano a “commutazione di circuito”, in pratica si instaura un circuito virtuale, simile a quello che si aveva agli esordi della telefonia con i centralini, tra le due terminazioni. Questa condizione era ottima per l’uso della rete che se ne faceva fino ad una decina d’anni fa, e cioè quello delle sole classiche telefonate, in cui c’è una continua comunicazione tra le parti solo in quel lasso di tempo. Nell’era internet una comunicazione simile non è accettabile in quanto tra due utenti o tra utente e gestore, c’è uno scambio di dati, anche di grosse dimensioni, ma non in maniera continua, e questa modalità è osservabile ad esempio nella navigazione su internet. Ed è proprio da qui che la NGN prende l’idea di una rete packet-switching.

La comunità di sviluppatori Java, riunita formalmente nell’associazione che prende il nome di Java Community Process (JCP), e più espressamente SUN hanno deciso di cogliere la sfida della realizzazione di piattaforme per il rapido sviluppo e installazione di componenti e servizi in grado di indirizzare anche le necessità della rete IMS.

Sono cosi nati diversi progetti che fanno parte di un piano di sviluppo a più ampio respiro chiamato JAIN, Java API for Intelligent/Integrated Network. JAIN raggruppa progetti che riguardano sia tecnologie di rete e protocolli, quale ad esempio JainSip, che tecniche per la creazione in modalità grafica di servizi.

È proprio qui infatti che vengono redatte le specifiche che prevedono la creazione e l’esecuzione dei servizi a valore aggiunto, che prendono il nome di Service Creation Environment (SCE) e Service Logic Execution Environment (SLEE).

Lo SLEE è un componente importante per la nuova NGN. Infatti rappresenta l’Application Server in cui risiedono le logiche dei servizi che danno “l’intelligenza” alla rete. La caratteristica di questa componente è quella di eseguire i servizi a valore aggiungo che un operatore può fornire ai propri clienti basandosi su informazioni esterne alla rete stessa. È quindi in grado di interfacciarsi a vari sistemi, come quelli di posta elettronica, presenza, fatturazione, server web, news e molti altri per poi erogare la prestazione per cui il servizio è stato realizzato.

Un componente di cui si sente la mancanza in un prodotto simile è quello che permette di poter schedulare in modo sofisticato una determinata prestazione nel tempo.

Il lavoro qui presentato vuole colmare questa mancanza sviluppando un modulo per l’Application Server JAIN SLEE che da la possibilità di fissare degli eventi nel tempo, come l’invio di SMS o la creazione di sessioni multimediali (conferenze/chiamate vocali), per la loro attivazione nell’instate di tempo indicato.

Vengono si seguito presentate tre sezioni, la prima illustra l’architettura di rete in cui i maggiori operatori stanno investendo, si tratta dell’IP Multimedia Subsystem (IMS), la futura piattaforma di rete con cui si realizzerà la NGN.

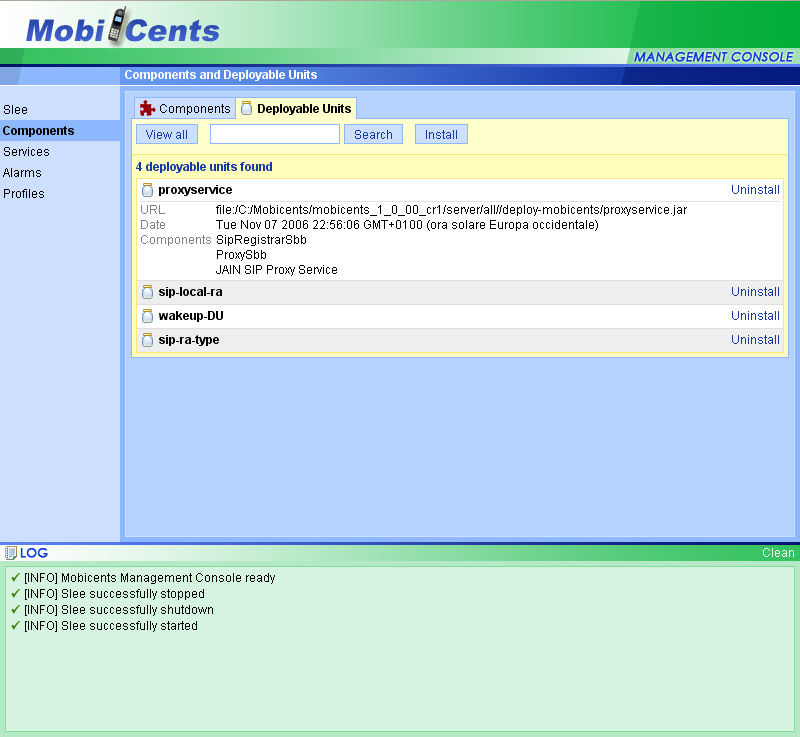

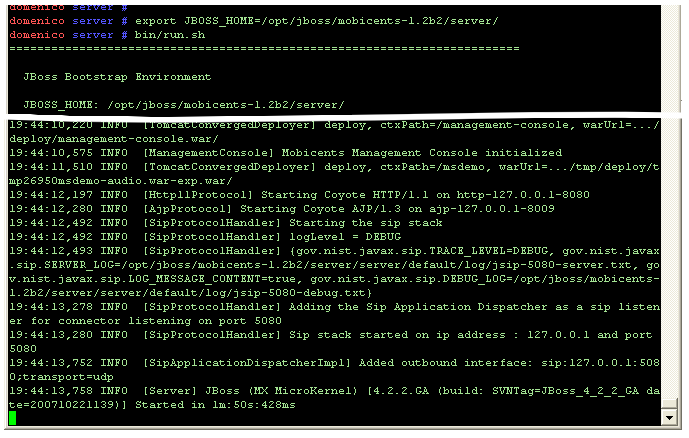

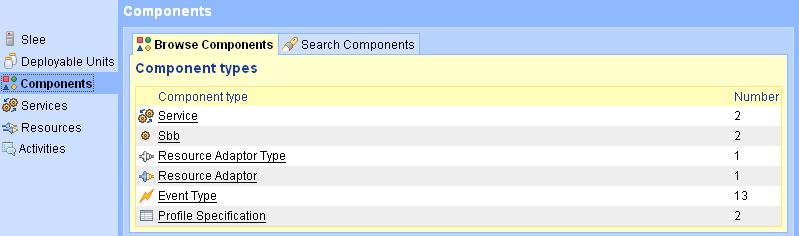

La seconda riguarda il funzionamento del nodo dell’infrastruttura che realizza l’Application Server, SLEE, e la relativa implementazione fornita da Mobicents, un prodotto open source compliant alle specifiche JAIN SLEE 1.1,

Nella terza parte vedremo come è stato realizzato lo sviluppo del modulo di SLEE che di occupa della calendarizzazione degli servizi, lo Scheduling Resource Adaptor.

Lo scenario

In questa prima parte vengono descritte le varie componenti che formano la futura infrastruttura di rete di un fornitore di servizi di telecomunicazioni. L’insieme prende il nome di IP Multimedia Subsystem (IMS), è uno standard internazionale che permetterà agli operatori di disporre di una piattaforma adatta a fornire servizi di tipo multimediale in maniera rapida con una totale conversione alle reti IP.

L’evoluzione delle tecnologie di comunicazione

Oggi “sembra” che per il telefono fisso gli anni stiano passando lentamente. È cambiato l’aspetto, più giovane, e la ruota è stata sostituita dai tasti, poco più comodi e veloci. Il sembra tra virgolette è d’obbligo, infatti se per noi utenti le differenze negli ultimi decenni sono state minime, dalla parte della centrale telefonica l’innovazione è stata importante. Infatti si è passati da centrali elettromeccaniche a quelle elettriche, evolutesi in centrali elettroniche in grado di offrire servizi come richiamata su occupato, segreteria telefonica, avviso di chiamata, e negli ultimi anni a centrali computerizzate (softswitch) in grado di far passare la nostra voce attraverso la rete intranet/internet per una maggiore efficienza, capacità e controllo.

La fonia mobile invece ha fatto passi da gigante da entrambi i punti di vista (utente e centrale). Ripercorriamo brevemente quella che è stata l’evoluzione della telefonia mobile dalla sua nascita. In base alla tecnologia radio usata, la storia del telefonino è suddivisa in generazioni:

|

0G

|

si usa per indicare tutti i sistemi di telefonia precedenti all’uso di tecniche di trasmissione dette a celle (quindi trasmissioni per-cellular). Questi telefoni erano generalmente montati sulle auto e camion per le loro dimensioni e il loro peso. Le tecniche trasmissive usate erano MTS (Mobile Telephone System), IMTS (Improved MTS) e AMTS (Advanced MTS), tutte analogiche e che impegnavano un intero canale radio per ogni comunicazione (originariamente erano 3 i canali per l’intera area metropolitana!). I primi sistemi di questo tipo risalgono, commercialmente parlando, al 1946, quando la Motorola insieme a Bell System offrirono in America il primo servizio di telefonia mobile usando il sistema MTS. |

|

1G

|

questa generazione segna la nascita dei sistemi cellulari, realizzati intorno al 1975-80. Il nome deriva infatti dalla suddivisione che si fece del territorio, a celle appunto, per inserire un maggior numero di BTS (Base Transceiver Stations, il “ripetitore” del telefonino) e sfruttare così il riuso delle frequenze per aumentare la capacità della rete. La rete è di tipo analogico, si sviluppa contemporaneamente nel mondo anche se con tecnologie diverse e non interoperabili. NMT (Nordic Mobile Telephone) è usata in Svizzera, Norvegia, Russia, mentre AMPS (Advanced Mobile Phone System) negli Stati Uniti, TACS (Total Access Communications System) nel Regno Unito, C-450 in Germania Est, Portogallo e SudAfrica, Radiocom 2000 in Francia, RTMS (Radio Telefono Mobile di Seconda Generazione) prima e il TACS (dal ‘91) poi in Italia. JTACS (Japan Total Access Communications System) in Giappone. |

|

2G

|

GSM. Questa è la rivoluzione della seconda generazione di telefonia mobile. Dopo circa 10 anni di lavori e sperimentazioni, nasce in Europa lo standard Global System for Mobile Communications, frutto della collaborazione di produttori, operatori, amministrazioni pubbliche, service provider, enti di ricerca ed utilizzatori (più di 650 membri anche extra-europei) riuniti nell’organismo indipendente ETSI (European Telecommunications Standards Institute). Il GSM è uno standard che prevede l’uso di tecniche cellulari (come la prima generazione), la modulazione di frequenza TDMA (Time Division Multiple Access) per far comunicare contemporaneamente più utenti sullo stesso canale e una trasmissione completamente digitale e cifrata delle informazioni. Questo nuovo standard permise l’interoperabilità tra reti di operatori e Stati diversi e di conseguenza la nomadicità dell’utente dove era presente un operatore GSM (roaming nazionale/internazionale). Un’estensione alla rete GSM si ebbe con l’introduzione, nel 2001, del GPRS (General Packet Radio Service) che supporta la trasmissione dati a pacchetto su reti GSM. Detto anche 2.5G, il GPRS rappresenta l’anello che lega le reti 2G a commutazione di circuito con le future 3G, a commutazione di pacchetto (reti simili ad internet piuttosto che alla telefonia tradizionale). Una successiva evoluzione del GPRS si ha con l’introduzione dell’EDGE (Enhanced Data rates for GSM Evolution), datata 2003, detto non ufficialmente 2.75G, che aumenta la velocità di connessione reale dai 50-60 kb/s a 150-200 kb/s. |

|

3G

|

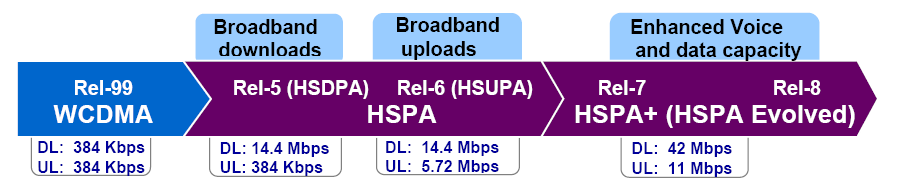

in altre parole, l’UMTS (Universal Mobile Telecommunication System). È lo standard del 3GPP per implementare servizi innovativi e multimediali wireless, realizzando la convergenza tra internet e comunicazione mobile (vedi Cap2: 3GPP). Realizzato dopo un studio durato anni, e ancora in evoluzione, l’UMTS è la risposta ai bisogni di alta velocità degli utenti utilizzatori di tecnologie multimediali. Videochiamate (considerata dagli analisti la killer-application del 3G, rivelatasi poi una previsione errata), VoIP, MMS, scambio di immagini, navigazione al alta velocità su internet, sono solo alcuni delle nuove opportunità che realizza il 3G. Le velocità promesse sono paragonabili alle prime ADSL, vanno dai 144 kbit/s ad oltre 3 Mbit/s dipendentemente dalla distanza dalla BTS e dalla velocità con cui si sposta il terminale mobile. Nonostante la partecipazione al progetto dei maggiori player a livello mondiale, e il loro sforzo a uniformare le tecnologie, non si è riusciti ad ottenere un unico standard per l’accesso al canale wireless (per diverse ragioni, anche politiche). Così abbiamo 3 grandi aree: WCDMA in Europa, CDMA2000 in America e il TD-SCDMA in Cina (quest’ultimo creato appositamente per scopi politico-economici). Anche qui, come per il 2G, ci sono delle evoluzioni intra-generazione: Sotto il nome di HSPA (High-Speed Racket Access) vengono raggruppate due protocolli che migliorano la codifica con cui i dati sono trasmessi e usano una differente modulazione del segnate: 3.5G, rappresenta la tecnologia HSDPA (High-Speed Downlink Packet Access) in grado di ricevere dati fino a 14,4 Mb/s e di trasmetterli fino a 384 kb/s (velocità teoriche, sappiamo che la realtà è ben diversa, si calcola che con l’aumentare dei dispositivi HSDPA la velocità possa scendere fino ad oscillare tra 0,5 e 1,5 Mb/s). Mentre il 3.75G è l’HSUPA (High Speed Uplink Packet Access), tecnologia che mira ad aumentare la velocità in uplink, che, in teoria, può raggiungere i 5 Mb/s. |

I fattori stimolanti di una nuova piattaforma

Negli ultimi vent’anni abbiamo visto evolvere il telefono, sia fisso che mobile, in una maniera esponenziale. Dalle semplici telefonate offerte agli utenti, si è passati a servizi sempre più evoluti quali le videochiamate i file sharing, instant messaging, servizi che fino a pochi anni fa erano solo ad appannaggio del web. La crescita è stata rapida e ha portato con se un’innovazione continua delle tecnologie che stanno alla base dei due mondi – fisso e mobile. Oggi siamo di fronte ad un nuovo traguardo, quello che da tempo, almeno gli addetti ai lavori, chiamano “convergenza fisso - mobile”. Una nuova era in cui, come un famoso spot pubblicitario ci fa notare, la rete, le comunicazioni, le informazioni sono tutte intorno a noi, dove non abbiamo nessuna barriera d’accesso, ma da qualunque posto e da qualunque dispositivo, possiamo accedere ai dati che ci necessitano.

La convergenza fisso mobile

Oggi si parla tanto di convergenza fisso - mobile (FMC). Essa rappresenta l’integrazione dei sistemi wireless e wireline per creare un singolo network di comunicazione e servizi. Un esempio tipico di FMC è la possibilità di avere un unico numero sia per il cellulare che per il fisso, quindi un unico terminale che è in grado di allacciarsi alla rete WiFi quando disponibile (per fare le cosiddette VoIP calls, chiamate dalla rete internet a costo nullo o molto basso), o alla rete GSM/GPRS/UMTS dell’operatore fuori del raggio d’azione della rete casalinga, passando da una rete all’altra senza interrompere la comunicazione.

Il ruolo dei Media

Una rete che permette la fruizione di video, inteso sia come chiamata video che come IPTv o videosharing come i grandi portali YouTube, TuoVideo ecc., la navigazione veloce in internet (quella vera, non col WAP…) e quindi l’accesso a grandi e popolari siti come MySpace, MSN, Yahoo non fa altro che aumentare l’interesse delle media company che guardano a queste tecnologie come il punto d’incontro con l’utente finale. La possibilità che hanno gli utenti si caricare e scaricare i contenuti, ancorché autoprodotti, è un vero punto di forza e lo si è visto anche dal crescente successo del Web 2.0 e dai servizi di collaborazione usati sia nel tempo libero che come strumenti per migliorare la produttività lavorativa.

Anche la pubblicità gioca un ruolo fondamentale nei nuovi sistemi. Oggi quella di internet diventa paragonabile, in termini di volume d’affari, a quella di giornali, riviste e radio, e la possibilità di conquistare un cosi vasto pubblico attraverso il nuovo Mobile Web 2.0 fa gola a molti.

I nuovi servizi

Oltre alle media company, l’interesse a nuove e più performanti reti di comunicazione si fa sentire anche da software house che potranno sviluppare soluzioni innovative anche a problemi già affrontati, incrementando il proprio bacino d’utenza. Un esempio, molto concreto e che ha avuto un grosso boom negli ultimi anni, è la navigazione satellitare. Grazie alla rilevazione della posizione tramite GPS o triangolazione del punto dai dati provenienti dalle antenne GSM, ed alla connessione ad internet, il sistema sarà in grado di fornirci informazioni dettagliate sul traffico e consigliarci il percorso più rapito tenendo in considerazioni fattori come ingorghi, velocità di percorrenza sulla determinata strada e rallentamenti.

Un altro esempio molto interessante di applicazioni creabili con la nuova piattaforma è sempre relativo alla pubblicità, e più precisamente, si avrà la possibilità di renderla sensibile alla posizione geografica di chi la “usufruirà”. Se da una parte questa forma di comunicazione è vista negativa e superflua soprattutto se non riguarda i propri interessi, dall’altro, se il messaggio viene selezionato in base alle proprie ricerche e interessi, e viene fornito ad inserzionisti che non si trovano più lontano di un paio di isolati dall’attuale posizione, può essere molto utile e adeguato non solo per l’inserzionista ma anche per chi la pubblicità la riceve.

Gli organi di standardizzazione

Diverse entità si sono occupate, e continuano ad occuparsi, della creazione delle specifiche tecniche e non su cui si basano i recenti sistemi di telecomunicazioni. Diamo un accenno alle più importanti.

Third Generation Partnership Project – 3GPP

Fu fondato nel 1998, è un progetto a cui fanno parte gli enti e consorzi che si occupano di standardizzare i sistemi di telecomunicazioni nelle diverse parti del mondo, autorità governative e regolatorie, operatori del mercato IT, ne fanno parta ad esempio ARIB, CCSA, ETSI, ATIS, TTA e TTC (alcune di queste descritte sotto). Lo scopo originale del 3GPP era di produrre le specifiche riguardanti la terza generazione di telefonia mobile, evoluzione del GSM, sia per la core network che per la parte d’accesso radio, sviluppando l’UTRA (Universal Terrestrial Radio Access). Gli su comunque assegnato anche il compito di sviluppare e mantenere le specifiche tecniche per il Global System for Mobile communication (GSM) nella loro evoluzione del GPRS e dell’EDGE.

Internet Engineering Task Force – IETS

È l’organismo che si occupa di definire gli standard di internet e la loro evoluzione. È aperto a chiunque sia interessato o voglia dare un contributo, il lavoro viene maggiormente svolto sulle mail list dei gruppi di lavoro che di occupano delle relative tematiche con degli incontri fissati a cadenza quadrimestrali.

La collaborazione con il 3GPP è definita nell’RFC3113. Qui si elencano le ragioni della collaborazione (il 3GPP userà gli standard dell’IETF mentre quest’ultimo potrà contare sulle capacita e sulle conoscenze che il 3GPP ha sulle reti wireless), la modalità di condivisione dei documenti, le comunicazioni e i partecipanti.

Il 3GPP ha adottato molti dei protocolli dell’IETF come l’IPv6, il Domain Name System (DNS), Session Initiation Protocol (SIP), Common Open Policy Service (COPS), Resource ReSerVation Protocol (RSVP), Session Description Protocol (SDP), Diameter (un protocollo per l’autenticazione, autorizzazione e la tassazione), Real-Time Protocol (RTP).

International Telecommunication Union –Telecommunication – ITU-T

È il settore relativo alle telecomunicazioni telefoniche e telegrafiche dell’Unione Internazionale delle Telecomunicazioni. Fornisce degli standard (o raccomandazioni) riconosciute a livello internazionale che regolamentano il settore TLC appunto.

European Telecommunications Standards Institute – ETSI

Fornisce standard a livello globale per l’ICT riguardanti telefonia fissa e mobile, convergenza, trasmissioni broadcast e tecnologie internet. È riconosciuto dalla Commissione Europea come L’Organizzazione Europea per la Standardizzazione. L’ETSI è una no profit formata dal almeno 700 membri di 60 nazioni.

Third Generation Partnership Project 2 – 3GPP2

É un progetto che si sviluppa sopra il 3GPP e che ingloba al suo interno l’IMS, qui chiamato Multi-Media Domain (MMD). Ci sono molte similitudini ma anche alcune differenze chiave come i codec usati, qui viene usato il Enhanced Variable Rate Codec (EVRC) al posto del Adaptive Multi-Rate (AMR). Altre riguardano la tassazione, le regole di controllo e servizi legacy.

Open Mobile Alliance – OMA

Formata nel giugno del 2002, l’Open Mobile Alliance mira alla standardizzazione dei servizi sui terminali mobili, il primo ad essere pubblicato è stato il Push-To-Talk over Cellular (PoC). L’OMA, impegnandosi in lavori come questo, permette a diversi fornitori di servizi di collaborare sulle funzioni chiave che il servizio stesso supporta, come la gestione delle sessioni, il QoS e la sicurezza, in modo da rendere i servizi interoperabili tra diversi fornitori.

IP Multimedia Subsystem

IP Multimedia Subsystem è un insieme di specifiche che descrivono la futura architettura per le reti di telecomunicazioni costruita sugli standard internet (IP) ed in grado di offrire servizi multimediali aggiuntivi rispetto alla sola fonia.

È un modello che vede ridurre il gap tra internet e i telefoni, grazie alla rete (fissa e cellulare) potremo infatti condividere con altre persone musica e video, giocare in real-time con altri player remoti, avere informazioni sul traffico riguardanti il nostro percorso, conferenze, chat, presenza e tanti altri servizi innovativi. L’uso di dispositivi con display ad alta definizione, potenti processori, always-on e always-connected ridefiniscono il concetto stesso di applicazioni per mobile devices.

Sicuramente non si tratta di uno scenario semplice, e tutte le sigle che indicano protocolli, server, funzionalità, interfacce non aiutano di certo. Cercheremo comunque di dare un minimo di consapevolezza su come funziona una rete IMS descrivendo leggermente gli elementi da cui è composta e le iterazioni esistenti tra di essi.

Alla fine faremo un paio di esempi relativi alla registrazione di un utente al sistema (la registrazione si ha al momento dell’accensione del telefono) e di una semplice chiamata telefonica (chiamata base in gergo tecnico).

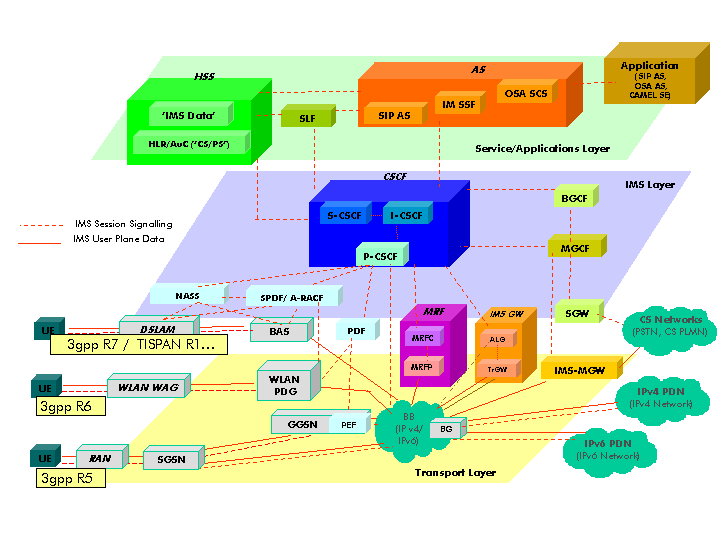

Panoramica di IMS

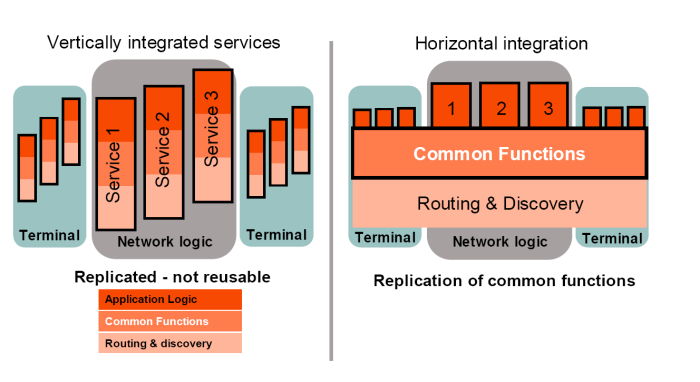

L’IMS si può vedere come una piattaforma stratificata orizzontalmente, composta da tre layer (vedi Figura 7), ognuno con responsabilità differenti. Non esiste più il concetto, come nelle reti tradizionali, che un unico sistema si occupi dell’intera catena esistente tra l’invocazione del servizio e il suo termine, ma grazie a questa stratificazione (orizzontale appunto) servizi diversi possono condividere gran parte dei loro elementi, permettendo un’elevata ricusabilità di soluzioni, facilità di integrazione dei servizi esistenti, riduzione dei tempi e dei costi di sviluppo (Figura 3).

Cosi stratificato e grazie all’adozione di reti full-IP, l’IMS garantisce la completa indipendenza dalla tecnologia di accesso e la possibilità di offrire tutti i servizi innovativi che una volta appartenevano al solo mondo di internet.

Anche la mobilità dell’utente ha la sua importanza, infatti IMS (Release 8) definisce i protocolli necessari per effettuare il cosiddetto handover sia tra reti omogenee che eterogenee. Ad esempi, il dispositivo mobile, durante una chiamata standard GSM, potrebbe accorgersi di avere a disposizione una WLAN a cui connettersi, ed effettuare un handover su questa, risparmiando sulla tariffazione dato che normalmente la connessione WLAN è molto più economica rispetto a quella GSM.

— Ericsson

L’evoluzione di IMS

Le origini dell’IMS hanno inizio nello stesso istante in cui fu fondato il 3GPP, nel dicembre 1998 a Copenaghen (Danimarca). Fino ad allora gli standard che vennero realizzati per la telefonia mobile e fissa erano firmati dall’ETSI (che definì anche lo standard GSM e GPRS), ma si sentiva la necessità di standardizzare a livello mondiale le nuove generazioni di reti wireless (in quegli anni era aperta la discussione sulla Terza Generazione).

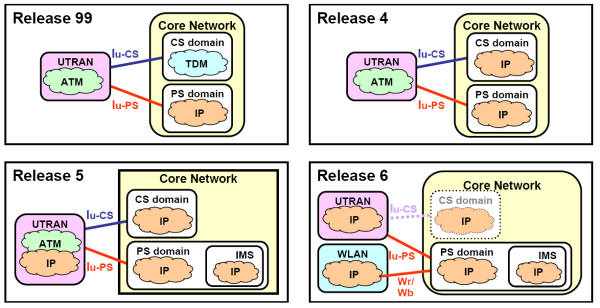

Le prime specifiche per le reti wireless 3G prime nascono nel 1999 prendendo il nome di Release 99 [3GPP R99].

La Release 99 è stata sviluppata in meno di un anno di lavoro grazie alla divisione dei compiti tra il 3GPP e l’ETSI. Il primo ha sviluppato i servizi, l’architettura, le codifiche WCDMA e TD-CDMA, UTRAN (UMTS Terrestrial Radio Access Network) e la parte di core network in comune con le reti esistenti, il secondo sviluppò il GSM/Enhanced Data Rates for Global Evolution (EDGE) e il relativo accesso GERAN (GSM Edge Radio Access Network). Queste specifiche consolidano le specifiche del GSM nella modalità a commutazione di pacchetto e preparano la rete a sostenere il notevole traffico di dati generato dalla futura architettura IP.

La Release 4 è stata rilasciata nel 2000. Il nome originare era Release 2000, che includeva la tecnologia All-IP, poi chiamata IMS, ma l’eccessivo lavoro rese necessario la divisione della release in Release 4 e Release 5. Anche per questo, i contenuti della Release 4 sono significamente diretti a ottimizzare e migliorare quelli della release precedente (UTRAN), ma non mancano le novità: il concetto di MSC Server-MGW, il protocollo IP nella core network, LCS (Location Services) per l’UTRAN.

La Release 5 introduce l’IMS, standard per l’accesso indipendente basato su IP e dialogante con le reti esistenti di voce a data per le connessioni fisse e mobili. L’architettura IMS rende possibile l’instaurazioni di connessioni peer-to-peer IP con tutti i tipi di client e oltre a gestire le sessioni IP, ha tutto il necessario per la completa fornitura di servizi (registrazione, sicurezza, fatturazione, roaming, controllo degli accessi, ecc.). Tutto questo forma il cuore della nuova architettura core full-IP. Fa parte di queste specifiche anche l’High Speed Downlink Packet Access (HSDPA).

La Release 6 similmente alla release 4, è un consolidamento di ciò che è stato fatto nella 5, con delle aggiunte importanti: l’accesso attraverso WLAN, l’implementazione del Qualità of Service, l’introduzione del concetto di Presenza dell’utente (informazioni aggiornate in real-time sullo stato della persona chiamata) e l’introduzione dei servizi punti-multipunto ottimizzati per il trasporto di contenuti multimediali, sia in modalità broadcast sia in modalità multicast (Multimedia Broadcast/Multicast Service, MBMS). Si sono avuti anche miglioramenti ai servizi: Location Services, Multimedia Messaging, QoS, codec audio e HDUPA (High Speed Uplink Packet Access).

La Release 7 aggiunge il supporto per all’elemento TISPAN (Telecoms & Internet converged Services & Protocols for Advanced Networks) che abilita gli utenti di rete fissa ai servizi multimediali della rete IMS, e quindi alla vera convergenza. Migliora l’High Speed Packet Access con l’introduzione del HDPA+ (HDPA Evolved) che raddoppia la capacità dei dati rispetto alla Release 5 e 6. Il Location Services per la WLAN, SMS/MMS su protocollo IP, Multimedia Telephony (MMTel), Voice Call Continuità (VCC) tra VoIP IMS e la rete a commutazione di circuito, ISM Emergency Calls, End to end QoS, Parlay X WS sono tra le nuove features della release. Degna di nota è la nuova interfaccia ICSI/IARI (IMS Communication Service ID / IMS Application Reference ID) che permette l’accesso alla core network da parte di applicazioni custom esterne alla rete dell’operatore.

— gsmworld.com

— Politecnico di Madrid

— Wind Telecomunicazioni

Uno sguardo al futuro

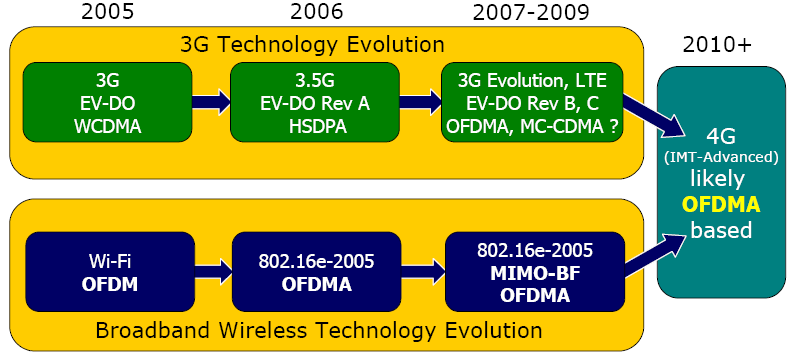

Il mondo corre verso il 4G mobile, che vedrà la luce (nelle prime forme) nel 2009, ma già dal 2008 ne saranno poste le fondamenta. Quest’anno sarà un succedersi delle prime aste per le frequenze ideali alla nuova generazione di servizi (2,3-2,6 GHz) e vedrà l’arrivo di prodotti per il WiMax nomadico o mobile. Il 4G porterà al culmine la guerra degli standard e forse vi porrà fine.

Due le tecnologie pronte a sfidarsi: WiMax mobile (802.16e) e Lte (Long Term Evolution).

Anche se sono frutto di due diversi organismi di standardizzazione, da fine 2007 sono stati messi nella stessa famiglia dell’IMT, la IMT-2000 che rappresentano un set di raccomandazioni dell’ITU per le reti d’accesso 3G . Significa che gli operatori e i produttori di apparati potranno sviluppare entrambe le tecnologie sulle stesse frequenze. In comune hanno buona parte dell’infrastruttura di rete: la tecnologia radio OFDMA (Orthogonal Frequency Division Multiple Access, aumenta la capacità del canale radio grazie alla migliore tolleranza alle interferenze e al multipath), il fatto di essere full-IP, l’uso di tecnologie innovative per le antenne come Mimo (Multiple Input Multiple Output) e la codifica QAM 64.

Il tutto porta a un salto avanti delle prestazioni di picco e reali rispetto al 3G. La velocità teorica con il 4G è fino a 100 Mbps in mobilità; 1 Gbps da postazione fissa.

Tra WiMax mobile ed Lte ci sono alcune piccole differenze nell’interfaccia radio;

Lte permette inoltre una maggiore mobilità, mentre WiMax mobile accetta connessioni da apparati che si spostano fino a circa 100 km/orari. Lte supporta anche la tecnica FDD (Frequency division demultiplexing), più efficiente della TDD (Time division demultiplexing), la sola supportata ad oggi dal WiMax mobile. Inoltre Lte è la diretta evoluzione dell’Umts, quindi gode di migliori potenzialità per gli studi già affrontati dalla generazione precedente e per le economie di scala . Di contro, Lte è in ritardo di circa un anno rispetto al WiMax mobile, almeno sulla roadmap commerciale.

Un altro standard 4G è l’Ultra mobile broadband, l’evoluzione del Cdma2000, ma lo scarso appoggio dal mondo TLC e la sola applicabilità all’America fanno alzare la probabilità di un abbandono.

È possibile invece che con il 4G, attraverso Lte e WiMax Mobile, Europa e Nord America useranno gli stessi standard, mentre finora le reti mobili sono state divise tra Cdma/Cdma 2000 americano e Gsm/Umts europeo.

I principali produttori hanno presentato (e mostrato in azione) al Mobile World Congress 2008 di Barcellona apparati Lte, prevedendo i lanci al pubblico nel 2010.

Ma oltre ai prodotti e alle reti, servono le frequenze (quelle sui 3,4-3,6 GHz, già assegnate in Europa, sono troppo elevate per assicurare connessioni in mobilità).

Molti operatori quindi si stanno preparando per accaparrarsi frequenze più basse, come sta succedendo in USA dove si sta avviando l’asta per i 700 MHz a cui partecipano, oltre ai grandi operatori, anche potenti net company come Google e Verizon. Mentre in Giappone, con l’asta già finita, i primi servizi a usare queste frequenze sono previsti per il 2009.

Le licenze potranno essere usate non solo con il WiMax ma anche con tecnologie 3GPP tra il 3G e il 4G, cioè l’HSPA, che in Europa è arrivato a 7,2 Mbps e che, attraverso semplici aggiornamenti software può arrivare a 21 Mbps e diventare HSPA+ (HSPA Evolution). L’HSPA+ con il Mimo e il Qam 64 richiede, invece, un cambio di antenna arrivando così a 42 Mbps.

— Rysavy Research

Anche il 2,5 G continua a riservare sorprese: nel 2009 arriverà l’Evolved Edge, con velocità fino a 500 Kbps. È uno standard utile per ridurre l’abisso che c’è tra reti 2/2,5 G (tuttora le sole ad avere copertura totale in Europa) e l’Umts/Hspa.

L’architettura IMS

Il sistema è composto da molti attori che vengono raggruppati in tre insiemi (o layer) a seconda della funzione che svolgono. Per collegare questi elementi insieme c’è una varietà di protocolli, la maggior parte dei quali sviluppati in seno all’IETF (Internet Engineering Task Force, comunità internazionale di ricercatori, operatori, aziende che si occupano dell’evoluzione di internet attraverso la definizione di standard aperti). Il più importante tra questi, per la definizione di una rete IMS, è il SIP, Session Initiation Protocol, usato per la gestione delle sessioni di comunicazioni (audio, video, chat, ecc.).

Una nota molto importante di queste specifiche è che definiscono nel dettaglio i “blocchi” (detti anche function entities o service function) di cui sono composti i layer, descrivendo minutamente le varie interfacce usate all’interno del sistema per la comunicazione inter-entità. Questo permette ai singoli produttori di hardware/software di progettare soluzioni anche solo per un’entità presente nel sistema.

La rete IMS è costituita da tre strati logici, un “quarto”, non presente, è il livello utente (in pratica i terminali) che si trovano collegati al Transport Layer:

— wikipedia.org

I tre livelli (dal basso verso l’alto):

Transport and Endpoint Layer (o Network Connectivity Layer)

È lo strato che si interfaccia direttamente con l’utente, è praticamente la porta d’ingresso per i l’iterazione dall’esterno. È su questo strato che arrivano le richieste per i nuovi servizi, che si gestisce il protocollo RTP (i flussi dati per la voce e il video) ed è qui dove risiedono i gateway per l’interfacciamento con altri tipi di rete (SMSC, Softswitch, Mediaserver, ecc.), routers, switches.

Questo strato garantisce all’accesso al sistema indipendentemente dal reale mezzo trasmissivo, quali GPRS, CDMA2000, UTMS, ADSL, W/LAN, PSTN ecc.

IMS Layer (o Session Control Layer)

È il livello che si occupa della cosiddetta segnalazione (setup e teardown delle sessioni multimediali). Ingloba i server CSCF (Call Session Control Function), che gestiscono le sessioni SIP tra gli utenti e garantiscono il QoS per i servizi offerti. Ospita il server HSS (Home Subscription Server) che mantiene i profili utente, informazioni sul roaming, servizi sottoscritti, location, e altre informazioni necessarie relative all’utente e alla rete. Contiene inoltre l’MGCF (Media Gateway Control Function) e l’MRFC (Media Resource Function Controller) necessari per le iterazioni dei media tra diversi i diversi gateway del Trasport Layer (tra cui il BGCF, Breakout Gateway Control Function per l’iterazione con le reti PSTN/SS7).

Service/Application Layer

L’Application Layer gestisce la logica di business dell’intero sistema, è la parte che ospita gli Application Server implementati secondo le specifiche SLEE, Parlay/OSA e CAMEL. Implementa i servizi di nuova generazione come instant messaging, push to talk, video streaming. Si interfaccia alla parte sottostante (Session Control) attraverso un’importante interfaccia chiamata ISC (IMS Service Control) che descriveremo alla fine della sezione.

Requisiti architetturali

L’IMS deve rispondere a dei minimi requisiti dettati dal Third Generation Partnership Project, documentati in 3GPP TS 22.228 quali:

Connettività IP

Tutti gli apparati devono essere connessi attraverso protocollo IP per accedere ai servizi IMS, sia che l’utente è direttamente collegato alla rete del proprio operatore, sia che si trovi in roaming in una visited network (la visited network è la rete dell’operatore a cui è registrato l’utente e da cui passa per accedere ai servizi che il proprio operatore gli mette a disposizione). IPv6 è preferibile.

Indipendenza dall’accesso

L’IMS è progettato per essere indipendente dal mezzo con cui si accede, cosi può offrire servizi su ogni tipo di connessione che supporti il protocollo IP, quindi dispositivi che si connettono tramite GPRS, WLAN, xDSL, ISDN.

Qualità del servizio (QoS)

Le reti IP, ma in generate le reti a commutazione di pacchetto, al contrario delle reti a commutazione di circuito, per loro natura soffrono di ritardi di:

- Elaborazione

-

ogni router/switch che si trova in mezzo ai due nodi che si intendono scambiare dati deve analizzare il pacchetto per controllare l’integrità dello stesso e determinare il corretto instradamento.

- Trasmissione

-

è il tempo necessario per la trasmissione del pacchetto che dipende dalla lunghezza del pacchetto e dalla velocità della linea di trasmissione.

- Coda

-

i pacchetti in uscita non sempre vengono trasmessi immediatamente, in quanto la linea può essere impegnata per altre comunicazioni. In questo caso in pacchetto viene mantenuto in memorie e ritrasmesso appena la linea è liberà. Più la linea è usata, e più si avranno casi di congestione come quello descritto. In generale un canale IP non riesce a sostenere oltre 80% della sua capacità trasmissivo.

A causa di questi effetti è anche possibile che pacchetti inviati tra due stessi host in instanti non molto lontani subiscano ritardi differenti. Questo ritardo è indicato col termine jitter, molto importante quando si tratta di streams multimediali che devono essere usufruiti in real-time, come una conversazione telefonica. Per questo motivo si può anche verificare la condizione che i pacchetti possono arrivare al destinatario in un ordine differente dall’invio.

Un’altra caratteristica da tenere in considerazione è la perdita dei pacchetti che può avvenire per diverse occasioni. Un pacchetto ricevuto può essere corrotto, a causa di errori o disturbi durante la trasmissione, oppure il buffer di un commutatore risulta essere saturo e quindi il pacchetto scartato, o per errori di instradamento, link down ed altre ragioni.

Per i motivi visti sopra, la rete IMS deve implementare dei meccanismi di qualità del servizio (QoS, Quality of Service) in modo tale da ridurre i casi di inefficienza nelle comunicazioni. L’IMS all’avvio di una sessione multimediale negozia tra i dispositivi dei parametri, quali:

-

Tipo di media che è possibile scambiare (Video, Audio. ecc.) e direzione.

-

Bitrate degli stream, dimensione dei pacchetti e frequenza di invio.

-

Consumo di banda.

Dopo la negoziazione, la rete riserva parte delle risorse alla sessione appena avviata fino alla sua fine. Questo è molto importante quando al servizio è associato uno SLA (Service Level Agreement, accorso sul livello del servizio) dove, se non rispettato, si applicano le relative penali.

Sicurezza delle comunicazioni

La sicurezza è uno degli aspetti fondamentali, soprattutto nelle telecomunicazioni, a cui si deve prestare attenzione. L’IMS deve fornire un livello di sicurezza maggiore, o al massimo uguale, a quello che si ha oggi sulle reti GPRS.

Ogni comunicazione che attraversa la Core Network (CN), sia in ingresso che in uscita, passa attraverso i Security Gateway (SEG) posti appunto sui bordi della rete dell’operatore e quindi applicano le policy di sicurezza definite dall’operatore stesso.

Se la Core Network è protetta con le stesse caratteristiche da tutti i punti d’accesso è anche detta Network Security Domain, NDS.

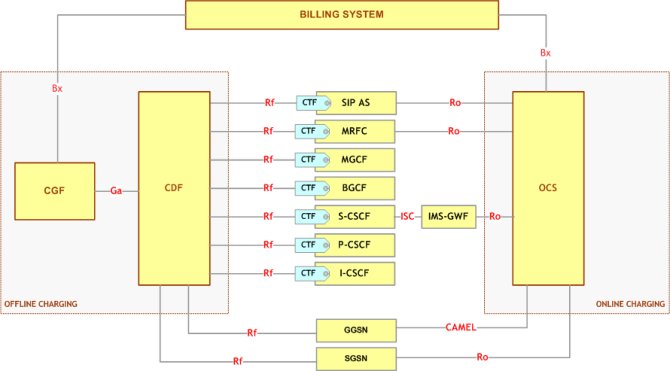

Fatturazione

Nell’IMS la fatturazione è realizzata in due modi, online e offline.

L’online charging è usato in quei servizi/sistemi preparati in cui il credito dell’utente viene via via scalato durante l’uso del servizio e interrotto al suo esaurimento. Nel secondo caso, l’offline, il servizio viene erogato e si generano solo le segnalazioni per la fatturazione, che avverrà per un relativo arco di tempo, ad esempio una volta al mese. In ogni caso, il sistema, prima di fornire un servizio, dovrà chiedere al sistema di billing se all’utente è permesso l’uso di tale servizio (procedura chiamata Credit Authorization).

— bea.com

Roaming

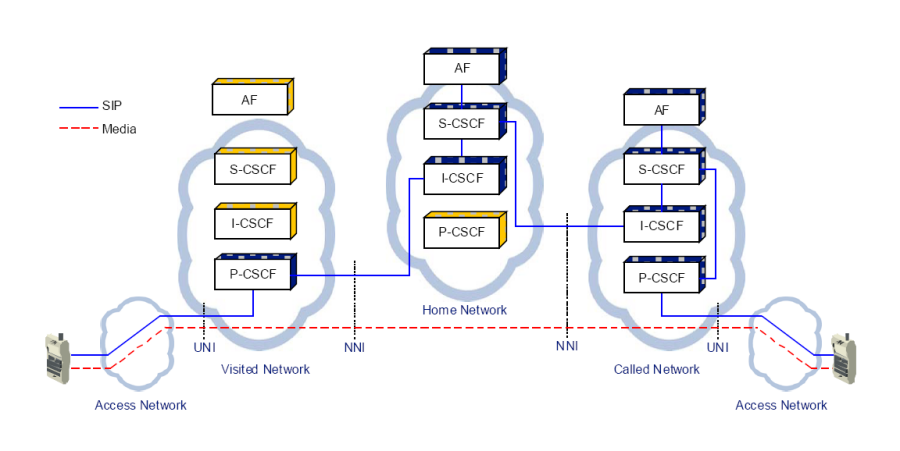

Dal punto di vista di un utente, è importante avere l’accesso ai propri servizi indipendentemente dalla posizioni in cui si trova. Il roaming dunque avviene quando un utente è connesso alla rete di un altro operatore e attraverso questa raggiunge i servizi messi a disposizione dal proprio gestore. In ambito IMS questo può avvenire in sue modi: GPRS o IMS roaming. Nel primo caso la rete a cui e connesso l’utente (visited network) fornisce l’accesso RAN e l’SGSN e la rete del proprio gestore (home network) fornisce il GGSN e l’IMS (la core network). L’IMS roaming si ha invece quando la visited network assegna la connettività IP (RAN, SGSN, GGSN e P-CSCF) e la core network del proprio operatore fornisce il resto. Il roaming IMS è preferibile in quanto utilizza in maniera ottimale le risorse che si trovano sul Connectivity Layer.

Interworking con le altre reti esistenti

L’IMS non verrà adottato da tutti gli operatori, o, per lo meno, non da tutti allo stesso tempo, né gli utenti cambiano terminale o abbonamento in maniera rapida. Per questo è stato necessario prevedere gateways per le reti più diffuse (descritti sotto) come le PSTN, ISDN, Internet.

Alcuni elementi chiave della rete IMS

Sono di seguito presentati alcuni elementi della rete IMS. Queste entità li possiamo grossolanamente classificare in sei principali categorie:

-

Gestione delle sessioni e instradamento (la famiglia dei server CSCF)

-

Database (HSS e SLF)

-

Internetworking (BGCF, MGCF, IMS-MGW, SGW)

-

Server per servizi GPRS (SGSN, GGSN)

-

Servizi (AS)

-

Gestione flussi multimediali (MRFC, MRFP)

-

Elementi di supporto (THIG, SEG, PDF)

-

Elementi per la fatturazione

P-CSCF (Proxy-Call Session Control Function)

Il P-CSCF è il proxy SIP che costituisce il primo punto di contatto tra il terminale dell’utente e l’IMS. Si può trovare nella visited network (la rete di un altro operatore) o nella home network (la propria rete) ma alcune volte è sostituito dal Session Border Controller. Il suo compito è quello di comprimete/decomprimere i messaggi SIP secondo le tre tecniche usate, validare i messaggi SIP ed esamina il contenuto SDP, inoltrare i messaggi SIP degli UE ai server I-CSCF o S-CSCF in base alla natura del messaggio, di generare i CDR (Call Detail Record) delle sessioni multimediali instaurate e di implementare le policy decision function (PDF) per autorizzare/negare determinati servizi.

I-CSCF (Interrogating-Call Session Control Function)

L’I-CSCF è un proxy SIP stateless posizionato agli estremi di un dominio amministrativo ed è un punto di contatto per tutte le connessioni destinate ad un utente in roaming attualmente all’interno dell’area coperta da un altro operatore. L’I-CSCF interroga l’HSS usando le interfacce DIAMETER Cx e Dx per ottenere la posizione dell’utente e quindi istradare le richieste SIP verso il suo S-CSCF assegnato. Fino alla Release 6, uno dei suoi ruoli era quello di nascondere la topologia della rete al mondo esterno criptando parte del messaggio SIP. In questa modalità, prende anche il nome di THIG (Topology Hiding Interface Gateway). Dalla Release 7 in poi, questa funzione viene rimossa dall’I-CSCF ed è ora parte dell’IBCF (Interconnection Border Control Function). L’IBCF è usato come gateway verso le reti esterne e fornisce delle funzioni di NAT e Firewall (pinholing).

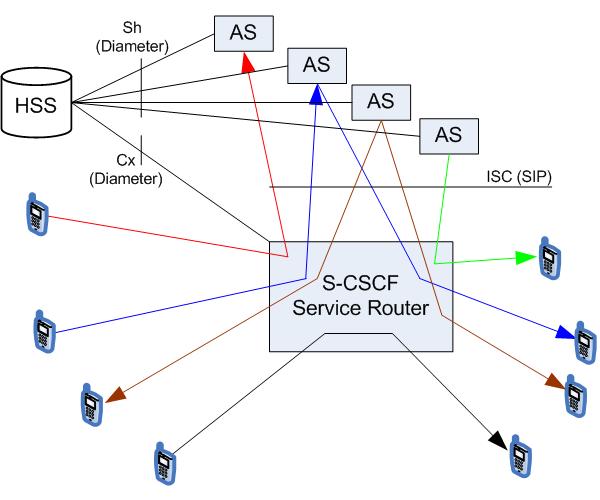

S-CSCF (Serving-Call Session Control Function)

L’S-CSCF è il nodo centrale della rete di segnalazione, in quanto ha il compito di eseguire il setup, la modifica ed il rilascio delle sessioni multimediali su IP. L’S-CSCF si trova sempre nell’home network ed usa le interfacce Cx e Dx DIAMETER per effettuare download ed upload di user profiles dall’HSS, non avendo una memoria locale dei dati utente. In base al tipo di utenti coinvolti nella conversazione, ha la capacità di interrogare gli I-CSCF o i gateways verso la rete PSTN per garantire la conversazione tra utenti di reti diverse.

HSS (Home Subscriber Server) e SLF (Subscription Locator Function)

HSS è il database principale e contiene tutte le informazioni dei profili utente, si interfaccia con i server SIP per fornire le informazioni per le procedure di autenticazione ed autorizzazione e può fornire dati relativi alla posizione fisica dell’utente. L’HSS inoltre contiene le informazioni relative all’S-CSCF assegnato all’UE registrato.

Quando il numero di utenti diventa di grandi dimensioni, è possibile suddividere la mole di dati tra diversi server HSS. In questo caso entra in gioco il server SLF, che, interrogato prima da chi intende fare una query al database, restituisce l’indirizzo dell’HSS relativo all’utente oggetto della query.

Entrambi utilizzano il protocollo DIAMETER per scambiare informazioni con gli altri elementi dell’architettura attraverso le interfacce nominate Dh, Sh, Dx, Cx.

SGSN (Serving GPRS Support Node)

L’SGSN è il link tra l’accesso radio (RAN) e l’IP core network. È responsabile sia del controllo che del trasporto dei dati da e per il dominio PS. La parte di controllo è formata dal Mobility Management che gestisce la posizione, lo stato e l’autenticazione dell’utente e dalla parte di Session Management che si occupa della creazione della sessione dati e al suo mantenimento. Media la sessione dati tra lo UE e il GGSN fornendo un tunnel per i dati utente e assicura un QoS appropriato.

GGSN (Gateway GPRS Support Node)

La prima funzione del GGSN è dare al UE la connettività IP sulla rete esterna dove risiedono applicazioni e servizi. La “rete esterna” in questo caso può rappresentare sia la core network IMS che Internet. È del GGSN il compito di assegnare un indirizzo IP al client e contattare il PDP e il sistema di charging per le rispettive autorizzazioni e fatturazione.

L’Application Server (AS)

L’Application Server è un server SIP che ospita la logica dei servizi e li esegue, interfacciandosi con l’S-CSCF per ottenere le informazioni relative agli utenti. In base al servizio in esame, può funzionare in modalità proxy SIP, modalità SIP UA (User Agent) o in modalità SIP B2BUA (Back-to-Back User Agent). Di solito è utilizzato per gestire sessioni multiutente che coinvolgono l’impiego di risorse multimediali. In questi contesti, il suo ruolo è quello di gestire dinamicamente l’aggiunta o rimozione di partecipanti e monitorare le informazioni relative alla conferenza (e.g. tempo di inizio, durata, lista dei partecipanti e così via).

MRF (Media Resource Function)

L’MRF provvede alla gestione dei media nella home network, si usa per processare dati multimediali (audio e video), effettuare conferenze o chat con sessioni di lavoro collaborative, conversioni Text-To-Speech (TTS) e riconoscimento di linguaggio, conversione in tempo reale di dati multimediali con codifiche diverse. Ogni MRF è diviso in due unità funzionali: l’MRFC (Media Resource Function Controller) e l’MRFP (Media Resource Function Processor).

MRFC: Costituisce un nodo del piano di segnalazione, agisce come un SIP User Agent per l’S-CSCF e controlla il MRFP mediante una interfaccia H.248 MEGACO o Real-Time Streaming Protocol (RTSP). Il suo obiettivo è quello di eseguire i comandi SIP provenienti dall’S-CSCF o gli script VoiceXML provenienti dall’Application Server per creare delle sessioni multimediali di varia natura.

MRFP: costituisce un nodo del piano di media ed implementa tutte funzioni legate ai media. Nell’MRFP sono implementati dei set di codecs, transcoders e funzioni per il mix di diversi media per fornire la possibilità di manipolare l’audio ed il video nello strato di connettività. MRFP è pilotato dall’MRFC ed è diviso in media bridges per applicazioni real-time (conference bridging e transcoding) e media player per applicazioni di streaming (voice mail, notifiche di rete e servizi di informazione).

PDF (Policy Decision Function)

Il PDF è dove vengono memorizzate le regole per descrivere quali sessioni sono autorizzate e quali non in base alle informazioni ottenute dalla sessione e dai metadati provenienti dal server P-CSCF.

BGCF (Breakout Gateway Control Function)

Il BGCF è un server SIP che include la funzionalità di routing basata sui numeri di telefono. È usato soltanto quando si effettua una chiamata da un terminale IMS ad un telefono in una rete a commutazione a circuito come Public Switched Telephone Network (PSTN) o Public land mobile network (PLMN).

MGCF (Media Gateway Control Function) e IMS-MGCF (IMS-Media Gateway Function)

L’MGCF è il gateway per comunicare con le reti a commutazione di circuito (CS) PSTN, quindi è un convertitore di protocollo SIP ←→ ISUP (ISDN User Part [4], sistema di segnalazione usato sulle reti PSTN) e si appoggia alla sua controparte MGF per controllare anche il flusso audio, quindi per la conversione dei flussi audio tra la rete IMS e la PSTN (RTP PCM) e dà il necessario per fornire toni e annunci alla parte residente sulla PSTN.

SGW (Signaling Gateway)

L’SGW è un gateway per l’interconnessione alle altre tipologie di reti di segnalazione, tra SIP e SS7 (Signaling System No.7 usato nelle reti PSTN) [5]. Opera solo a livello di protocollo e non interpreta i messaggi del livello applicazione (SIP, ISUP, BICC, ecc).

SEGs (Security Gateways)

I SEGs sono entità che si posizionano sul bordo della rete IMS dell’operatore e sono usati per mettere in sicurezza le comunicazioni in ingresso e in uscita. Ce ne possono essere più di uno per tematiche relative alla fault tolerance e performance.

I protocolli alla base di IMS

Come detto precedentemente, i vari service function di cui è composto l’IMS comunicano tra di loro, e con l’esterno, usando protocolli standardizzati da IETF e ITU. Descriviamo a grandi linee quelli più importanti.

SIP – Session Initiation Protocol (RFC 3261)

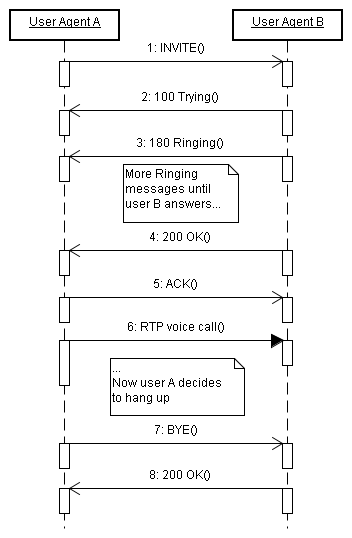

Il Session Initiation Protocol gestisce in modo generale una sessione di comunicazione tra due o più entità.

Nasce in seno all’IETF per far fronte al crescente numero di applicazioni che necessitano dell’instaurazione di una sessione di comunicazione, quindi non soltanto in ambito IMS, e consente di stabilire/modificare/terminare sessioni multimediali indipendentemente dal protocollo di trasporto sottostante e dal tipo di dati (Audio, Video, Testo e/o altri).

SIP è un protocollo peer-to-peer, di tipo testuale, simile all’HTTP, e per questo permette una lettura del messaggio senza molte difficoltà dagli umani. Infatti è stato progettato tenendo sempre presente principi come la semplicità, flessibilità ed estensibilità, tipici del più noto protocollo del web, l’HTTP, contrariamente al suo SS7. Il livello di trasporto su cui si basa di default è l’UDP, con porta 5060, ma le ultime estensioni prevedono anche l’uso di TCP e SCTP. La sua funzione principale, come abbiamo già detto, è la segnalazione (gestione della sessione) ed è per questo che lavora in insieme ad altri protocolli, quali SDP e RTP, per la gestione completa della comunicazione multimediale.

Gli attori che il protocollo SIP prevede di avere sono quattro e ognuno di essi può partecipare ad una comunicazione SIP come client (colui che effettua una richiesta) o server (chi risponde) o entrambi. Un singolo dispositivo può svolgere le funzioni di uno o più attori SIP, come avviene ad esempio per un server Proxy che può svolgere funzioni si Registrar. Queste entità logiche che prevede SIP sono:

- User Agent

-

è un endpoint, come un telefono. L’User Agent si comporta sia da client che da server. La parte client (UAC, User Agent Client) inizia il dialogo SIP mentre la parte server (UAS, User Agent Server) risponde alle richieste in arrivo.

- Proxy Server

-

è un intermediario tra attori SIP. Si usa per far passare messaggi SIP tra reti diverse, quindi interpreta, e se è necessario modifica, gli stessi quando lo attraversano.

- Redirect Server

-

è un server che accetta richieste SIP e le mappa con gli indirizzi SIP del destinatario del messaggio, che possono essere zero (se il destinatario è sconosciuto dal Redirect) o più nuovi indirizzi. Diversamente dal Proxy, questo risponde al mittente della richiesta e non la passa a nessun altro. È usato quando il destinatario vuole essere rintracciato ad un’altra locazione.

- Registrar

-

è un server che accetta solo richieste di tipo REGISTER con cui l’utente notifica alla rete la sua locazione, quindi fa sapere alla rete stessa come può essere rintracciato.

— DataConnection.com

I messaggi che il protocollo prevede sono:

-

Richieste:

-

INVITE, usate per iniziare una sessione o per cambiarne i parametri (re-INVITE).

-

ACK, conferma una risposta.

-

BYE, termina una sessione.

-

CANCEL, ferma il precedente evento.

-

OPTIONS, richiede le caratteristiche supportate dalla controparte.

-

REGISTER, registra lo User Agent presso il Registrar Server.

-

INFO, manda informazioni durante una sessione senza modificarne lo stato.

-

-

Risposte, numeriche a 3 cifre di tipo:

-

Provvisorio

-

Classe 1xx, risposte provvisorie che il server trasmette per indicare lo stato di progresso della transazione SIP, ma non la terminano.

-

-

Finale:

-

Classe 2xx: indica un successo.

-

Classe 3xx: redirezione o forwarding.

-

Classe 4xx: richieste fallite (errori del client).

-

Classe 5xx: errori del server.

-

Classe 6xx: errori globali (utente occupato, non raggiungibile…)

-

-

SDP – Session Description Protocol (RFC 4566)

L’SDP è un protocollo testuale che descrive i parametri di inizializzazione degli multimediali. Non fornisce quindi il contenuto della comunicazione, ma semplicemente un meccanismo per la negoziazione tra il mittente e il destinatario delle codifiche utilizzate per la trasmissione dello flusso multimediale. È usato in una varietà di contesti inclusi SIP, SAP (Session Announcement Protocol) da cui è nato, RTP/RTSP, HTTP ed estensioni MIME.

Le informazioni che trasporta riguardano:

-

Il nome delle sessioni e il loro scopo

-

Tempo di vita della sessione

-

Il tipo di codec usato

-

Come ricevere il flusso (indirizzi, porte e protocolli)

-

Larghezza di banda necessaria

-

Contatti della persone responsabile della sessione.

Le informazioni sono nel formato <chiave>=<valore> e usano la codifica UTF-8.

Questo è un esempio di messaggio SIP (in alto) contenente un SDP (in basso) separati da una riga vuota:

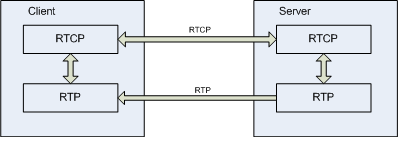

RTP – Real-Time Protocol (RFC 3550)

É un protocollo che fornisce un servizio di trasporto dati con caratteristiche di real-time, semplificata fornitura, monitoraggio, ricostruzione, mixing e sincronizzazione di flussi audio/video.

È spesso usato su connessioni inaffidabili come l’UDP (User Datagram Protocol), non fornisce QoS, prenotazioni di risorse, ma sincronizzazione tra flussi multimediali, verifica dei pacchetti persi per una stima della qualità, riordino dei pacchetti all’arrivo. È stato ideato sia per trasmissioni unicast che multicast.

Non ha porte di default e questo rende necessario l’uso di un altro protocollo, STUN (Simple traversal of UDP over NATs), quando siamo in presenza di una rete con NAT. È spesso usato in congiunzione con RTCP (Real-time Transport Control Protocol), definito nella stessa RFC, che raccoglie statistiche sulla qualità del servizio, informazioni sui partecipanti, byte trasferiti, jitter, round trip delay, ecc. in una connessione parallela all’RTP.

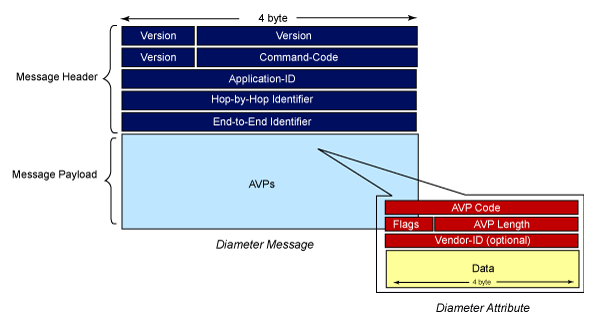

Diameter (RFC 3588)

Il Diameter è il protocollo che implementa i meccanismi di Authentication, Authorization e Accounting (AAA). Definito nell’RFC 3588, il funzionamento di base prevede un’architettura peer-to-peer e l’uso di protocolli di trasporto come TCP o SCTP.

Il nome Diameter deriva da un gioco di parole riferito al protocollo che va a sostituire ed estendere, il Radius (Remote Authentication Dial-In User Service). Rispetto a questo migliora il protocollo di trasporto, che ora si basa sui più affidabili TCP o SCTP rispetto all’UDP, la sicurezza (posso essere impiegati IPsec e TLS), l’estendibilità (adesso sono presenti 32 bit per indirizzare il nome di un parametro contro 8 dei precedenti), la scoperta automatica di nuovi peer (usando i record DNS SRV e NAPTR), la gestione degli errori e molto altro.

Il protocollo Diameter definisce un appoggio su cui sviluppare ulteriori protocolli, infatti le specifiche Diameter Base precisano la capacità di stabilire connessioni tra i peer, il routing tra di essi, la gestione delle sessioni, il rilevamento di connessioni cadute, ecc. ma sono necessarie estensioni specifiche per i servizi che si vogliono usare, alcune sono:

- Mobile IP

-

permette lo scambio di informazioni tra le reti a cui il terminale mobile si aggancia duramente i suoi spostamenti.

- NASREQ (Network Access Server Requirements)

-

è usata per fornire servizi di AAA in modalità dial-in PPP (Point-to-Point Protocol).

- Ro Application

-

accounting di tipo on-line.

- Rf Application

-

accounting off-line.

- Sh Application

-

richieste tra Application Server e HSS.

Le estensioni Diameter non sono altro che un insieme di parametri a cui è associato un valore, i cosiddetti AVP (Attribute Value Pair). Questi non solo altro che una rappresentazione di dati come nome-valore, progettati per prendere la struttura che li contiene (in questo caso il messaggio Diameter) aperto ad estensioni e futuri cambiamenti senza la necessità di modificare il codice che lo gestisce.

Dato che si tratta di un protocollo p2p, ogni host che implementa il protocollo Diameter opera sia come client che come server per questo ci si riferisce all’host col termine nodo. Nonostante questo, viene denominato client il peer che effettua la richiesta e server colui che risponde. Come nel caso di SIP, anche nel Diameter un nodo può rappresentare una o più funzione logiche, cosi oltre al client ed al server esistono degli Agent. Gli Agent sono nodi che introducono flessibilità all’architettura, hanno svariati scopi tra cui quello di concentrare le richieste di un vasto gruppo di Diameter client in pochi nodi della rete, load balancing, redirezione delle richieste ecc.

Esistono diversi tipi di Agent:

- Relay Agent

-

è usato per spedire il messaggio alla destinazione corretta basandosi sulle informazioni che il messaggio stesso contiene. È vantaggioso usarlo quando si vogliono aggregare richieste provenienti da domini diversi (Realm) ad una specifica destinazione eliminando la necessità di configurazioni multiple.

- Proxy Agent

-

sono molto simili ai Relay ma con più funzionalità. Infatti i Proxy Agent oltre a rigirare le richieste ai server di destinazione, sono in grado di verificare lo stato di collegamento con i peer, attuare politiche di load balancing ed è in grado di modificare il contenuto del messaggio in base a determinate politiche.

- Redirect Agent

-

non fa altro che rispondere alle richieste indicando al mittente il server che è in grado di soddisfarle. Rappresenta in un certo senso un repository centralizzato per la configurazione dei nodi Diameter. È molto utile in quegli scenari in cui sono presenti molti Proxy Agent e non si vuole replicare la configurazione dei nodi-realm su ognuno di essi.

- Translation Agent

-

come il nome fa immaginare, questo tipo di Agent converte i messaggi diameter in altri formati. È utile in quei casi in cui il passaggio a Diameter avviene in fasi graduali e i nuovi sistemi devono poter interfacciarsi con i vecchi. Nella maggior parte dei casi la traduzione avviene tra Diameter e Radium o tra Diameter e TACACS+, che sono gli altri due protocolli di AAA a sui Diameter si sostituisce.

— ibm.com

L’interfaccia ISC (IMS Service Control)

Questo è un paragrafo fondamentale per capire il collegamento esistente tra l’architettura IMS che gli operatori si stanno attrezzando a implementare e descritta fin qui con le specifiche JAIN SLEE della SUN presentare nella parte successiva.

Ricordando l’architettura dell’IMS (Figura 7), possiamo notare che nel Service/Application Layer sono preseti i server che implementano le logiche di business. Questi server sono collegati ai server CSCF attraverso l’interfaccia denominata ISC, che trasporta messaggi SIP, e possono operare come SIP UA (User Agent), SIP B2BUA (Back-to-Back User Agent), Conference server, Presence server ed offrire molti altri servizi. Sono anche collegati ai server HSS/SLF attraverso le interfacce Sh, Ro, ed Rf, basate su Diameter, per recuperare e memorizzare informazioni relative alla rete e agli utenti e per fornire informazioni al sistema di fatturazione relativamente ai servizi offerti.

Le procedure che coinvolgono l’ISC si possono dividere in due categorie:

-

Richieste che partono da elementi di rete o da utenti, e che, attraverso l’S-CSCF, possono raggiungere l’AS. L’S-CSCF inoltra le richieste all’AS in base all’analisi del messaggio SIP e alle politiche che vengono implementate dalla rete. In questi casi, l’AS può terminare, ridirigere e proxare richieste SIP, anche ad altri AS sempre attraverso gli S-CSCF. Scenari come Text-To-Speak o Richiamata su occupato appartengono a questa categoria.

-

Richieste per partano dall’AS, quindi l’AS come inizializzatore della sessione. Questo caso raggruppa gli scenari in cui l’AS è visto come un SIP User Agent, o che si comporta come un Back-to-Back User Agent.

In riferimento al primo caso descritto, quando è l’S-CSCF a contattare l’AS, lo fa basandosi su quello che viene definito Initial Filter Criteria (IFC). Questi non sono altro che parametri memorizzati nel profilo utente (quindi residenti nell’HSS), sezione service-triggering, e dipendenti dai servizi che l’utente (chiamante o chiamato) ha sottoscritto.

Oltre a descrivere il servizio in base al quale attivarsi, contengono informazioni sull’AS a cui girare la richiesta, la priorità con cui devono essere eseguiti i servizi che si attivano su identici avvenimenti, informazioni relative ai casi in cui si ha un AS che non risponde, e poche altre.

Sempre in riferimento al caso in cui è l’AS a ricevere una richiesta dall’S-CSCF, il comportamento che può assumere l’AS stesso si può riassumere in quattro punti:

-

Terminating UA: l’AS assume il comportamento di un UE (Figura 13, freccia rossa). È usata ad esempio nel caso della voicemail o per gestire la propria presenza in rete su un server di Presence.

-

Redirect server: l’AS informerà il mittente sulla nuova destinazione a cui è possibile raggiungere l’utente.

-

SIP Proxy: si comporta a tutti gli effetti come un proxy SIP e è in grado di aggiungere, rimuovere o modificare gli header contenuti nella richiesta SIP.

-

Third-party call control/B2BUA: l’AS genererà uno nuovo dialogo SIP e si comporterà come un back-to-back User Agent. In questo caso ha un maggiore controllo della sessione rispetto al caso precedente (in blu nella figura).

Da notare nella Figura 13 che in nero è il caso in cui né il chiamato né il chiamante hanno sottoscritto servizi aggiuntivi, situazione di una semplice chiamata base. Mentre in verde si nota la reazione che vede l’AS iniziatore del dialogo SIP, ad esempio nel caso in cui, sempre relativamente ad un caso di presenza, il Presence Server (AS) notifica ad un utente il cambiamento di stato di un contatto.

Parte Seconda: JAIN SLEE e Mobicents

Dopo aver visto, seppur a grandi linee, l’intera architettura IMS andiamo ad approfondire il punto in cui risiederanno le logiche di business. L’Application Server che andremo ad analizzare implementa le specifiche JAIN SLEE, Java APIs for Advanced Intelligent Networks Service Logic Execution Environment. Questo può essere utilizzato come Applicationi Server in ambito IMS per la gestione ed erogazione dei servizi intelligenti.

SLEE, attraverso i suoi connettori denominati Resource Adaptor, si interfaccia tramite Sip e Diameter (con i protocolli ISC ed Sh rispettivamente) col mondo IMS.

La descrizione dei moduli da cui è composto JAIN SLEE, del modo in cui avviene l’interazione tra di essi e col mondo esterno alla piattaforma SLEE e di Mobicents (la prima e sola piattaforma open source certificata che implementa questa tecnologia) sono trattati nella presente sezione.

la JAIN Initiative

Java è sinonimo di modularità, interfacce standard, portabilità delle applicazioni da piccoli dispositivi a grossi cluster di server, ma soprattutto di Java Application Programming Interfaces (APIs). Queste ultime sono necessarie per fornire un adeguato livello di astrazione tra moduli software anche sviluppati da diversi enti.

Tutto questo nel mondo delle telecomunicazioni è racchiuso nel nome JAIN, Java APIs for Intelligent Network o anche Java APIs for Integrated Network.

La “JAIN Initiative”, come viene spesso definita, è una comunità di esperti nell’ambito delle telecomunicazioni uniti per definire un insieme di tecnologie che danno la possibilità di sviluppare rapidamente prodotti e servizi per le reti di nuova generation, le cosiddette NGN. Questa unione si è resa sempre più necessaria dall’esordio delle tecnologie di seconda e terza generazione (2.5G e 3G). Le architetture erano, come abbiamo già visto, verticalmente e non condividevano uno standard collettivo per integrarsi e fornire servizi più complessi. JAIN fa della portabilità, indipendenza dalla rete e dello sviluppo aperto i suoi cavalli di battaglia per portare un nuovo livello di astrazione nei servizi integrati internet/telefono che renderà la creazione di migliaia di servizi innovativi un processo semplicissimo rispetto ad oggi.

Le API sviluppate in seno alla JAIN Initiative includono, tra le altre cose, API per il controllo delle chiamate, messaggi (instant messaging), presence, servizi basati sulla posizione.

L’iniziativa vede Sun come società leader nel progetto di sviluppo di queste tecnologie, progetto che va sotto il nome di Java Specification Participation Agreement (JSPA) e Java Community Process (JCP), accompagnata da altri colossi come IBM, Motorola, NTT DoCoMo e Vodafone.

Obiettivi

Gli obiettivi con cui la JAIN Initiative intende realizzare la propria infrastruttura e far convergere gli operatori al proprio modus operandi sono:

-

Service portability - portabilità di un servizio da una piattaforma all’altra grazie alla standardizzazione delle API.

-

Network convergence - convergenza delle comunicazioni grazie all’astrazione fornita dalle API, quindi indipendenza dal mezzo di comunicazione (es. SS7 o IP e grazie all’IMS).

-

Service Provider Access - permettendo alle applicazioni che girano fuori dal dominio dell’operatore di interagire in maniera sicura e controllata al network del provider sfruttando le nuove possibilità di accesso.

Questi sono gli stessi punti che hanno portato al successo la piattaforma J2EE nell’industria IT. La rimozione delle soluzioni proprietarie e la standardizzazione verso soluzioni open semplificherà lo sviluppo e l’installazione di nuove componenti java, tutto a minor prezzo. Da parte dei Network Operator si avrà una maggiore competitività nel fornire soluzioni in tempi più brevi e potranno scegliere i loro fornitori di componenti da un vasto bacino in base a funzionalità e valore aggiunto.

Le componenti di JAIN

Oltre a SLEE, la JAIN iniziative ha standardizzato API come:

-

JAIN Session Initiation Protocol (JSIP) – è la definizione di uno stack SIP in Java che fornisce i meccanismi base del protocollo SIP da implementare in gateway, client, server. Questo non include le funzionalità per la gestione del flusso multimediale, ma ha tutto il necessario per realizzare User Agent, Proxy, Registrar e Redirect Server.

-

Java Call Control (JCC) – è una libreria che permette la gestione, il monitoraggio, l’inizializzazione, la risposta e l’elaborazione di chiamate multimediali (voce e/o video). Le applicazioni che fruttano questa libreria si occupano solo di gestire l’interfacciamento all’API, sarà quest’ultima a interagire le reti sottostanti indipendentemente dalla loro tipologia (wireless, wireline e Internet).

-

Server APIs for Mobile System (SAMS) – sono le APIs che gestiscono messaggi (SMS e MMS), presenza e posizione dei terminali mobili lato server.

-

Mobile Device Management and Monitoring (DM) – permettono il monitoraggio, la gestione della configurazione, dei software e delle librerie installate dei dispositivi mobili da un punto centrale, i server dell’operatore al quale il device si sincronizza.

-

SIP for J2ME – sono delle API che forniscono alla piattaforma J2ME la possibilità di connettersi via SIP e poter effettuare chiamate. Sono basate sul Generic Connection Framework del J2ME Connecter Limiter Device Configuration (CLDC) ed usano le esistenti classi di I/O del CLDC.

-

Location for J2ME – permettono agli sviluppatori della piattaforma J2ME di conoscere la posizione del dispositivo. È sempre basata su CLDC.

-

Wireless Messaging API (WMA) – fornisce l’accesso, sempre da J2ME (sia CLDC che MIDP), al sottosistema wireless del dispositivo. Da l’accesso al Unstructured Supplementary Service Data (USSD) e al Cell Broadcast Service (CBS) per scambiare lo scambio di dati o per ricevere le informazioni che la stazione base trasmette in modalità broadcast.

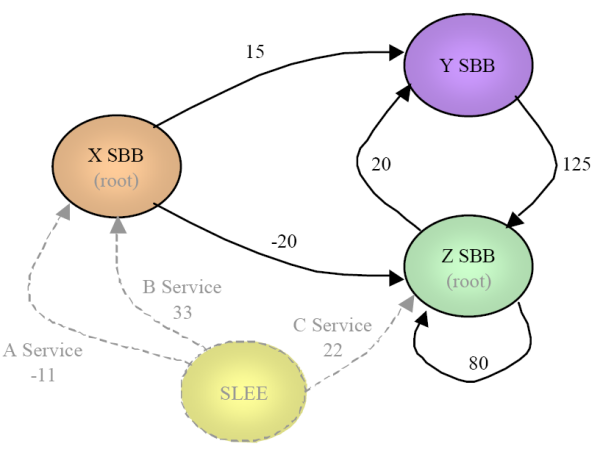

JAIN Service Logic Execution Environment

Lo SLEE definisce un modello di architettura orientata a componenti per la creazione di logiche applicative, non solo di servizi di comunicazione, ma di tutte quelle applicazioni che possono essere guidate da eventi e/o messaggi ed hanno elevati throughput mantenendo bassi tempi di risposta.

Le specifiche non definiscono l’implementazione di SLEE né la tecnologia sottostante, bensì le interfacce, le relazioni tra esse e le iterazioni con l’ambiente host che esegue SLEE, lasciando liberi i produttori di differenziare i loro prodotti e favorire la concorrenza tra tecnologie diverse.

Grazie alla standardizzazione di queste interfacce, le applicazioni sviluppate con SLEE possono essere formate da una collezione di oggetti riusabili che a loro volta possono essere applicazioni SLEE. Questo facilita la creazione e la composizione di servizi sempre più complessi.

JSLEE prevede meccanismi di scalabilità, performance e robustezza anche se non definisce particolari strategie con cui concretamente realizzare queste caratteristiche. Un server che implementa le specifiche SLEE rappresenta quindi un container per lo sviluppo di applicazioni guidate da eventi o messaggi asincroni. Questo, come vedremo, è un aspetto molto importante del sistema poiché si distingue dalle altre specifiche che usano una logica di risposta sincrona, come le Sip Servlet.

In aggiunta al modello a componenti, JSLEE definisce l’interfaccia di gestione amministrativa dell’Application Server e un set di “Facilities”. Quest’ultimi forniscono allo sviluppatore di servizi una serie di funzioni di utilità per le operazioni più comuni.

Al processo di sviluppo sono intervenuti, oltre alla SUN, anche i contributi provenienti da società del settore TLC e non, come Open Cloud, jNetX, Telecom Italia, Università di Genova, Telecordia, NIST ed altre.

Gli obiettivi

Questa piattaforma mira a:

-

Definire uno standard per lo sviluppo di applicazioni di comunicazione object-oriented a componenti nel linguaggio di programmazione JAVA.

-

A sviluppare applicazioni che si combinano, o che sono basate, su componenti sviluppati con altri tool o da differenti aziende.

-

A nascondere lo strato sottostante la definizione del servizio stesso: lo sviluppatore non è tenuto a conoscere o gestire dettagli quali il multi-threading, connection pooling, transazioni e altre api di basso livello.

-

Grazie all’uso di Java e alla filosofia Write Once, Run Anywhere™, le applicazioni scritte e compilate per una determinata piattaforma conforme a SLEE “dovrebbero” (il condizionale è sempre d’obbligo) essere installati ed eseguiti un qualunque altra piattaforma senza modificare o ricompilare il codice sorgente.

-

Facilitare gli aspetti di sviluppo, installazione e configurazione e ciclo di vita delle applicazione telecom.

-

Definire le interfacce per un’architettura a plug-in dei Resource Adaptor per facilitare lo sviluppo e la portabilità nelle differenti implementazioni di JSLEE.

-

Definire le interfacce che facilitano l’interoperabilità tra applicazioni sviluppate da vendors diversi.

-

Compatibilità con J2EE: sia JSLEE che i server J2EE devono poter convivere nello stesso sistema e collaborare per fornire servizi integrati e convergenti (internet e telefonia, SIP e HTTP).

-

Compatibilità con le specifiche Java Management Extensions (JMX) per la gestione dell’application server.

Il rapporto con J2EE

Java 2 Enterprise Edition è la piattaforma Java per le applicazioni che hanno elevati requisiti di stabilità, sicurezza, coerenza (transazionalità) e performance. È la risposta della Sun alle richieste di un sistema robusto, stabile e flessibile, mantenendo delle specifiche aperte per favorire l’integrazione di prodotti create da differenti case. Queste non solo altro che delle (consistenti) specifiche, le “solite” API, che mirano prima di tutto alla creazione di un ambiente data centrico.

SLEE è standardizzato per venire incontro alle richieste di real-time e di grandi throughput come il mondo delle comunicazioni può richiedere. JSLEE non è progettato per sostituire J2EE, né viceversa, bensì per integrarsi con esso e fornire un insieme completo di features, dando al mondo enterprise di J2EE meccanismi per l’elaborazione tipici di una piattaforma guidata ad eventi (event driven).

| Caratteristica | J2EE | JSLEE |

|---|---|---|

|

Tempo medio di esecuzione di una richiesta |

< 2 secondi Non real-time |

< 100 msec Soft real-time |

|

Media Transazioni completate |

1000/sec |

10000/sec |

|

Uptime |

99.9% (9 ore/anno) |

99.999% (5 min/anno) |

|

Esecuzione servizi (tipica) |

Sincrona |

Asincrona |

|

Modello transazionale |

Orientato al database, quindi pesanti e lente |

Piccole transazioni per la delimitazione della replica nel cluster, frequenti |

|

Persistenza |

Databases, EIS |

In memoria |

JAIN SLEE ha, come vedremo, implementato internamente un meccanismo di code su cui si basa il suo intero funzionamento. Alcuni possono obiettare che anche in J2EE esista un qualcosa di simile, e precisamente JMS. Benché lo scopo delle due code sia identico, in SLEE la creazione, distruzione e associazione ai consumer delle code è qualcosa che viene gestito dal container con centinaia di iterazioni al secondo. In JMS le cose vanno diversamente, in quanto le code (o i topics) vanno dichiarate nel setup dell’application server e persistono per tutta la vita del container.

Dopotutto le due tecnologie possono essere intergrate per usi specifici attraverso un adattatore SLEE←→JMS che permette lo scambio di messaggi tra i due ambienti.

La relazione con le SIP Servlet

Mentre JSLEE è un application server, le SIP Servlet (JSR 116) sono un’estensione del modello HTTP Servlet al mondo SIP. Sono state realizzare per semplificare la scrittura di applicazioni SIP (data la relazione con le Servlet) ed attrarre cosi più sviluppatori, fornendo solo uno stato software che fa da wrapper allo stack SIP implementato a più basso livello. Sono due tecnologie per sviluppare applicazioni SIP molto diverse. Una completa e modulare (JSLEE), l’altra piccola, leggera, rapida nella sua acquisizione, ma alcune volte scarna per aspetti importati (Sip Servlet). Naturalmente la scelta di una o dell’altra tecnologia è molto dipendente da ciò che si andrà a realizzare, ecco quindi una piccola lista delle differenze esistenti:

-

JSLEE astrae il livello di rete sottostante, SIP Servlet no.

-

JSLEE è molto più complesso delle SIP Servlet.

-

JSLEE supporta le transazioni, SIP Servlet no.

-

JSLEE definisce molte facility rispetto alla sola timer facility di SIP Servlet.

-

JSLEE definisce la gestione di manica si servizi e dati utente, SIP Servlet no.

-

JSLEE è molto più versatile e potente delle SIP Servlet, al costo della semplicità.

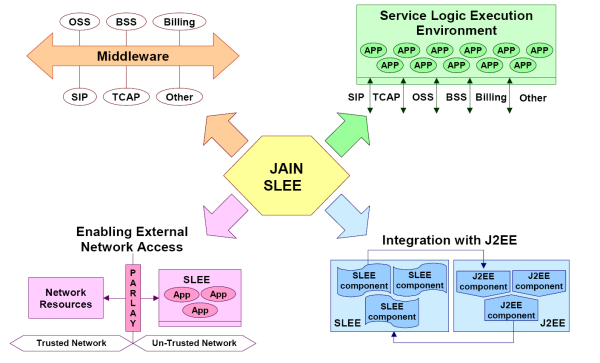

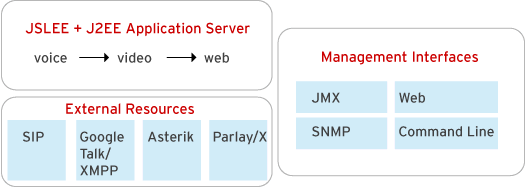

Integrazione di JAIN SLEE nel mondo TLC

Lo SLEE è adatto, date le sue caratteristiche, a una varietà di ambienti di comunicazione.

Infatti è in grado di interfacciarsi con:

-

Tecnologie di segnalazione tradizionali come SS7, ma anche le nuove 3G e NGN.

-

Tramite gateway Parlay/OSA/JSPA a reti già implementate che accettano AS tramite queste interfacce.

-

OSS/BSS (Operational and Business Support Systems) per fornire agli operatori e gestori delle reti un ambiente per la creazione e manutenzione dei servizi in maniera rapida ed efficiente (SCE, Service Creation Environment).

-

Server J2EE contenenti servizi già presenti in rete.

-

Sistemi di middleware, ed integrarsi con essi per fornire un completo ambiente per la realizzazione di servizi innovativi e complessi.

— OpenCloud.com

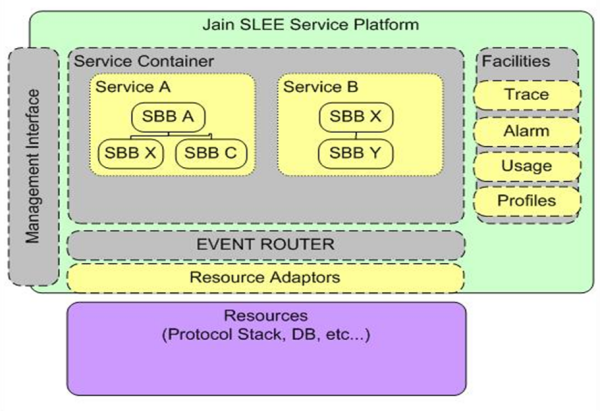

L’architettura

SLEE è formato da una serie di componenti che permettono l’esecuzione dei servizi in maniera asincrona , event-driven application.

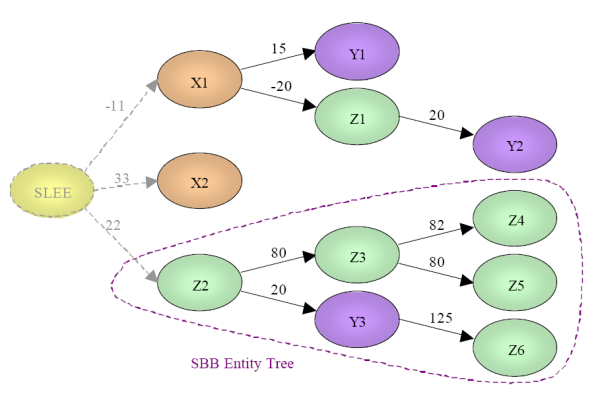

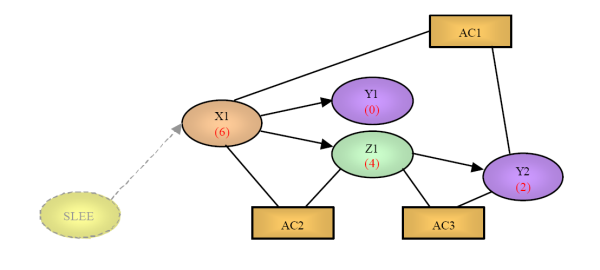

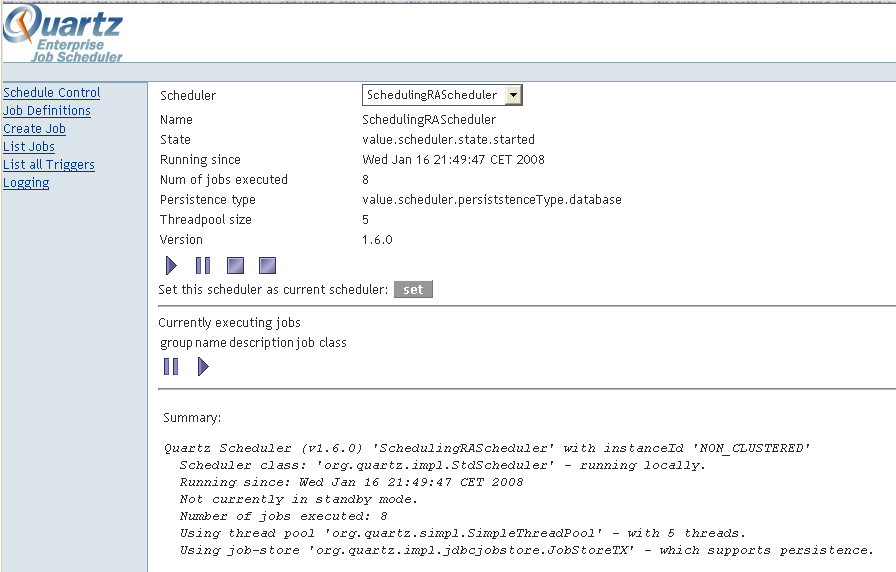

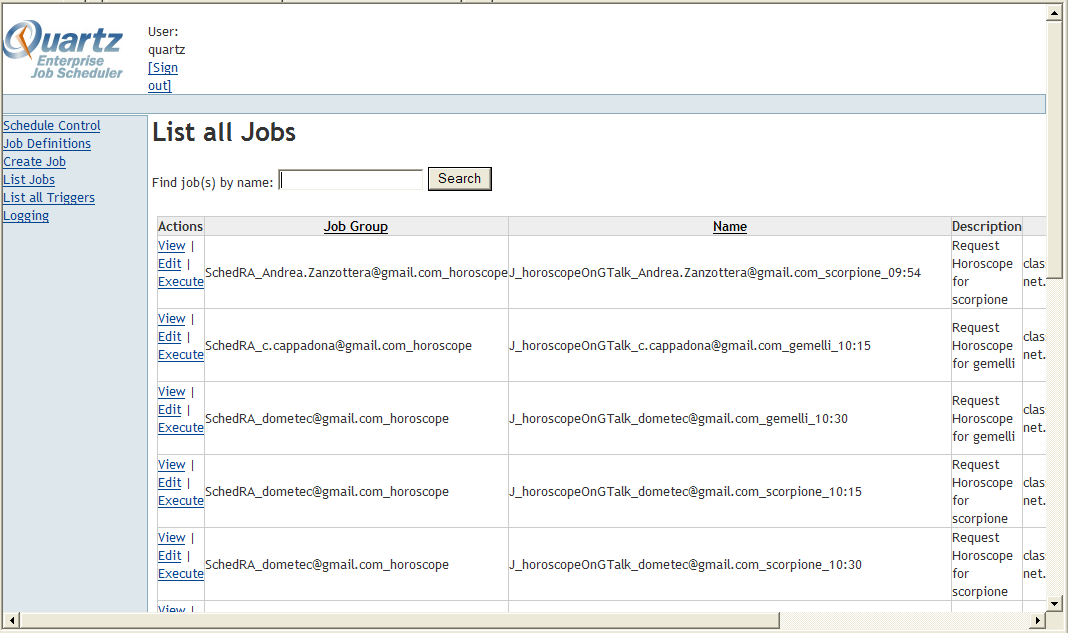

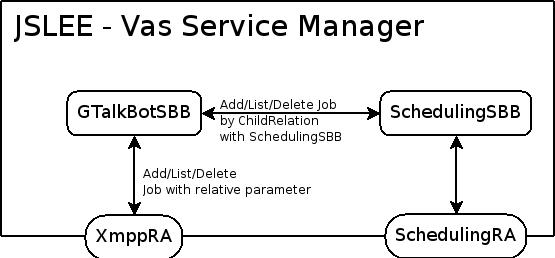

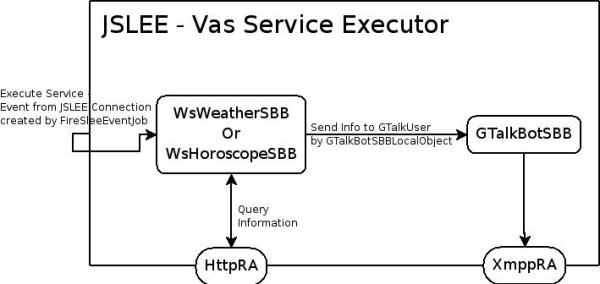

Di seguito possiamo osservare a grandi linee com’è composto JAIN SLEE (Figura 15). Possiamo osservare verticalmente le Facilities, che forniscono ai servizi (al centro) i metodi per gestire efficacemente e facilmente alcune funzioni tra le più comuni. Dal lato opposto, sempre verticalmente, è presente la Management Interface che si occupa della gestione e configurazione di servizi, risorse e modalità di funzionamento. Sotto possiamo trovare lo strato di Resource Adaptor, componenti dello SLEE che si occupano di astrarre l’architettura di rete e protocolli per presentare una “vista” Java delle risorse che si andrà ad utilizzare. Al centro possiamo osservare i servizi che sono installati internamente al container e la parte di Event Router, il processo che decide, in base ai messaggi in arrivo, ai servizi presenti e al loro ordine di priorità, dove dirottare i nuovi messaggi.

— jboss.org

SLEE definisce anche le interfacce per la memorizzazione dei dati relativi alla configurazione e di quelli relativi ai profili utenti, nascondendo come di consueto l’implementazione sottostante. Sarà quindi possibile salvare dati in XML, Database, Directory LDAP e molti altri tipi di storage usando le stesse procedure.